Numpy 만으로 신경망구현하기 (일반 기본 DNN)

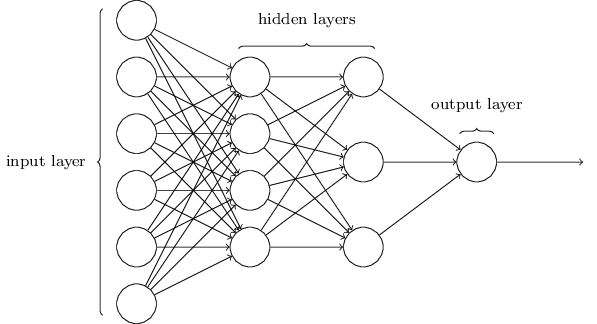

저번에 2층 DNN 구현을 한 것에 이어 일반화하여 hidden layer의 수를 n개 수용할 수 있는 DNN 을 구현했다. 추가된 것으로 활성화 함수로 relu 와 sigmoid 를 선택할 수 있고 L2 regularization 기능이 추가됐다. 또한 가중치들의 초기화로 relu 는 he 초기화, sigmoid 는 xavier 초기화가 된다.

라이브러리 코드 :

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 227 228 229 230 231 232 233 234 235 236 237 238 239 240 241 242 243 244 245 246 247 248 249 250 251 252 253 254 255 256 257 258 259 260 261 262 263 264 265 266 267 268 269 270 271 272 273 274 275 276 277 278 279 280 281 282 283 284 285 286 287 288 289 290 291 292 293 294 295 296 297 298 299 300 301 302 303 304 305 306 307 308 309 310 311 312 313 314 315 316 317 318 319 320 321 322 323 324 325 326 327 328 329 330 331 332 333 334 335 336 337 338 339 340 341 342 343 344 345 346 347 348 349 350 351 352 353 354 355 356 357 358 359 360 361 362 363 364 365 366 367 368 369 370 371 372 373 374 375 376 377 378 379 380 381 382 383 384 385 386 387 388 389 390 391 392 393 394 395 396 397 398 399 400 401 402 403 404 405 406 407 408 409 410 411 412 413 414 415 416 417 418 419 420 421 422 423 424 425 426 427 428 429 430 431 432 433 434 435 436 437 438 439 440 441 442 443 444 445 446 447 448 449 450 451 452 453 454 455 |

# coding: utf-8 import numpy as np from collections import OrderedDict #--------------------functions--------------------- def identity_function(x): return x def step_function(x): return np.array(x > 0, dtype=np.int) def sigmoid(x): return 1 / (1 + np.exp(-x)) def sigmoid_grad(x): return sigmoid(x) * (1.0 - sigmoid(x)) def softmax(x): if x.ndim == 2: x = x.T x = x - np.max(x, axis=0) y = np.exp(x) / np.sum(np.exp(x), axis=0) return y.T x = x - np.max(x) return np.exp(x) / np.sum(np.exp(x)) def mean_squared_error(y,t): return 0.5 * np.sum((y-t)**2) def cross_entropy_error(y,t): if y.ndim == 1: y = y.reshape(1,-1) t = t.reshape(1,-1) if t.size == y.size: t = t.argmax(axis=1) batch_size = y.shape[0] return -np.sum(np.log(y[np.arange(batch_size),t] + 1e-7)) / batch_size def softmax_loss(x,t): y = softmax(x) return cross_entropy_error(y,t) def _numerical_gradient_1d(f,x): h = 1e-4 grad = np.zeros_like(x) for idx in range(x.size): tmp_val = x[idx] x[idx] = float(tmp_val) + h f1 = f(x) x[idx] = tmp_val - h f2 = f(x) grad[idx] = (f1 - f2) / (2*h) x[idx] = tmp_val return grad def numerical_gradient_2d(f,X): if X.ndim == 1: return _numerical_gradient_1d(f,X) else: grad = np.zeros_like(X) for i,x in enumerate(X): grad[i] = _numerical_gradient_1d(f,x) return grad def numerical_gradient(f,x): h = 1e-4 grad = np.zeros_like(x) it = np.nditer(x, flags=['multi_index'], op_flags=['readwrite']) while not it.finished: idx = it.multi_index tmp_value = x[idx] x[idx] = float(tmp_value) + h f1 = f(x) x[idx] = tmp_value - h f2 = f(x) grad[idx] = (f1 - f2) / (2*h) x[idx] = tmp_value it.iternext() return grad def mini_batch(x_train, y_train, batch_size=200): random_lenght = np.random.permutation(x_train.shape[0]) mod = x_train.shape[0] // float(batch_size) for idx in np.array_split(random_lenght,mod): x_batch, y_batch = x_train[idx], y_train[idx] yield x_batch, y_batch #----------------------------------layers-------------------------------- class Relu: def __init__(self): self.mask = None def forward(self,x): self.mask = (x <= 0) out = x.copy() out[self.mask] = 0 return out def backward(self,dout): dout[self.mask] = 0 dx = dout return dx class Sigmoid: def __init__(self): self.out = None def forward(self,x): out = sigmoid(x) self.out = out return out def backward(self,dout): dx = dout * self.out * (1.0 - self.out) return dx class Affine: def __init__(self,W,b): self.W = W self.b = b self.original_x_shape = None self.x = None self.dW = None self.db = None def forward(self,x): self.original_x_shape = x.shape x = x.reshape(x.shape[0],-1) self.x = x out = np.dot(self.x,self.W) + self.b return out def backward(self,dout): dx = np.dot(dout,self.W.T) self.dW = np.dot(self.x.T,dout) self.db = np.sum(dout, axis=0) #편향 공유 데이터끼리 dx = dx.reshape(*self.original_x_shape) return dx class SoftmaxWithLoss: def __init__(self): self.y = None self.t = None self.loss = None def forward(self,x,t): self.y = softmax(x) self.t = t self.loss = cross_entropy_error(self.y,self.t) return self.loss def backward(self,dout=1): batch_size = self.t.shape[0] if self.y.size == self.t.size: dx = (self.y - self.t) / batch_size else: dx = self.y.copy() dx[np.arange(batch_size), self.t] -= 1 dx = dx / batch_size return dx class Dropout: def __init__(self, dropout_ratio=0.5): self.dropout_ratio = dropout_ratio self.mask = None def forward(self,x,train_flg=True): if train_flg: self.mask = np.random.rand(*x.shape) > self.dropout_ratio return x * self.mask else: return x * (1.0 - self.dropout_ratio) def backward(self,dout): return dout * self.mask #---------------------------------- 신경망 구현 -------------------------- class TwoLayerNet: def __init__(self,input_size, hidden_size, output_size, weight_init_std=0.01): self.params = {} self.params['W1'] = weight_init_std * np.random.randn(input_size, hidden_size) self.params['b1'] = np.zeros(hidden_size) self.params['W2'] = weight_init_std * np.random.randn(hidden_size, output_size) self.params['b2'] = np.zeros(output_size) self.layers = OrderedDict() self.layers['Affine1'] = Affine(self.params['W1'], self.params['b1']) self.layers['Relu'] = Relu() self.layers['Affine2'] = Affine(self.params['W2'], self.params['b2']) self.last_layer = SoftmaxWithLoss() def predict(self,x): for layer in self.layers.values(): x = layer.forward(x) return x def loss(self,x,t): y = self.predict(x) return self.last_layer.forward(y,t) def accuracy(self,x,t): y = self.predict(x) y = np.argmax(y, axis=1) if t.ndim != 1 : t = np.argmax(t, axis=1) accuracy = np.sum(y==t) / float(x.shape[0]) return accuracy def numerical_gradient(self,x,t): loss_W = lambda W : self.loss(x,t) grads = {} grads['W1'] = numerical_gradient(loss_W, self.params['W1']) grads['b1'] = numerical_gradient(loss_W, self.params['b1']) grads['W2'] = numerical_gradient(loss_W, self.params['W2']) grads['b2'] = numerical_gradient(loss_W, self.params['b2']) return grads def gradient(self,x,t): self.loss(x,t) dout = 1 dout = self.last_layer.backward(dout) layers = list(self.layers.values()) layers.reverse() for layer in layers: dout = layer.backward(dout) grads = {} grads['W1'] = self.layers['Affine1'].dW grads['b1'] = self.layers['Affine1'].db grads['W2'] = self.layers['Affine2'].dW grads['b2'] = self.layers['Affine2'].db return grads #--------------------------다층신경망------------------------------- class MultiLayerNet: """완전연결 다층 신경망 Parameters ---------- input_size : 입력 크기(MNIST의 경우엔 784) hidden_size_list : 각 은닉층의 뉴런 수를 담은 리스트(e.g. [100, 100, 100]) output_size : 출력 크기(MNIST의 경우엔 10) activation : 활성화 함수 - 'relu' 혹은 'sigmoid' weight_init_std : 가중치의 표준편차 지정(e.g. 0.01) 'relu'나 'he'로 지정하면 'He 초깃값'으로 설정 'sigmoid'나 'xavier'로 지정하면 'Xavier 초깃값'으로 설정 weight_decay_lambda : 가중치 감소(L2 법칙)의 세기 """ def __init__(self,input_size, hidden_size_list, output_size, activation='relu',weight_init_std='relu', weight_decay_lambda=0): self.input_size = input_size self.output_size = output_size self.hidden_size_list = hidden_size_list self.hidden_layer_num = len(hidden_size_list) self.weight_decay_lambda = weight_decay_lambda self.params = {} #가중치 초기화 self.__init_weight(weight_init_std) # __init_weight 이 뭐야? #계층 생성 activation_layer = {'sigmoid' : Sigmoid, 'relu' : Relu} self.layers = OrderedDict() for idx in range(1, self.hidden_layer_num+1): self.layers['Affine' + str(idx)] = Affine(self.params['W' + str(idx)], self.params['b' + str(idx)]) self.layers['Activation_function' + str(idx)] = activation_layer[activation]() idx = self.hidden_layer_num + 1 self.layers['Affine' + str(idx)] = Affine(self.params['W' + str(idx)], self.params['b' + str(idx)]) self.last_layer = SoftmaxWithLoss() def __init_weight(self, weight_init_std): """가중치 초기화 Parameters ---------- weight_init_std : 가중치의 표준편차 지정(e.g. 0.01) 'relu'나 'he'로 지정하면 'He 초깃값'으로 설정 'sigmoid'나 'xavier'로 지정하면 'Xavier 초깃값'으로 설정 """ all_size_list = [self.input_size] + self.hidden_size_list + [self.output_size] for idx in range(1, len(all_size_list)): scale = weight_init_std if str(weight_init_std).lower() in ('relu', 'he'): scale = np.sqrt(2.0 / all_size_list[idx - 1]) # ReLU를 사용할 때의 권장 초깃값 elif str(weight_init_std).lower() in ('sigmoid', 'xavier'): scale = np.sqrt(1.0 / all_size_list[idx - 1]) # sigmoid를 사용할 때의 권장 초깃값 self.params['W' + str(idx)] = scale * np.random.randn(all_size_list[idx - 1], all_size_list[idx]) self.params['b' + str(idx)] = np.zeros(all_size_list[idx]) def predict(self, x): for layer in self.layers.values(): x = layer.forward(x) return x def loss(self, x, t): """손실 함수를 구한다. Parameters ---------- x : 입력 데이터 t : 정답 레이블 Returns ------- 손실 함수의 값 """ y = self.predict(x) weight_decay = 0 for idx in range(1, self.hidden_layer_num + 2): W = self.params['W' + str(idx)] weight_decay += 0.5 * self.weight_decay_lambda * np.sum(W ** 2) return self.last_layer.forward(y, t) + weight_decay def accuracy(self, x, t): y = self.predict(x) y = np.argmax(y, axis=1) #index를 뱉어 if t.ndim != 1: t = np.argmax(t, axis=1) accuracy = np.sum(y == t) / float(x.shape[0]) return accuracy def numerical_gradient(self, x, t): """기울기를 구한다(수치 미분). Parameters ---------- x : 입력 데이터 t : 정답 레이블 Returns ------- 각 층의 기울기를 담은 딕셔너리(dictionary) 변수 grads['W1']、grads['W2']、... 각 층의 가중치 grads['b1']、grads['b2']、... 각 층의 편향 """ loss_W = lambda W: self.loss(x, t) grads = {} for idx in range(1, self.hidden_layer_num + 2): grads['W' + str(idx)] = numerical_gradient(loss_W, self.params['W' + str(idx)]) grads['b' + str(idx)] = numerical_gradient(loss_W, self.params['b' + str(idx)]) return grads def gradient(self, x, t): """기울기를 구한다(오차역전파법). Parameters ---------- x : 입력 데이터 t : 정답 레이블 Returns ------- 각 층의 기울기를 담은 딕셔너리(dictionary) 변수 grads['W1']、grads['W2']、... 각 층의 가중치 grads['b1']、grads['b2']、... 각 층의 편향 """ # forward self.loss(x, t) # backward dout = 1 dout = self.last_layer.backward(dout) layers = list(self.layers.values()) #list로 만들어줘야 가능 layers.reverse() for layer in layers: dout = layer.backward(dout) # 결과 저장 grads = {} for idx in range(1, self.hidden_layer_num + 2): grads['W' + str(idx)] = self.layers['Affine' + str(idx)].dW + self.weight_decay_lambda * self.layers[ 'Affine' + str(idx)].W grads['b' + str(idx)] = self.layers['Affine' + str(idx)].db return grads |

MNIST 히든레이어 2층 신경망 구현

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 |

# -*- coding: utf-8 -*- #import pymysql import sys, os sys.path.append(os.pardir) import numpy as np from keras.datasets import mnist from collections import OrderedDict from code1 import * (X_train,y_train),(X_test, y_test) = mnist.load_data() # data normalization X_train = X_train / 255. X_test = X_test / 255. X_train = X_train.reshape(-1,28*28) X_test = X_test.reshape(-1,28*28) hidden_size_list = [300,100] network = MultiLayerNet(input_size=784,hidden_size_list=hidden_size_list,output_size=10,activation='relu') iters_num = 50 train_size = X_train.shape[0] batch_size = 200 learning_rate = 0.1 train_loss_list = [] train_acc_list = [] test_acc_list = [] iter_per_epoch = max(train_size / batch_size, 1) # 키 리스트 생성 key_list = [] for i in range(1,len(hidden_size_list)+2): key_list.append('W' + str(i)) key_list.append('b' + str(i)) for i in range(iters_num): for X_batch, y_batch in mini_batch(X_train,y_train,batch_size=batch_size): grad = network.gradient(X_batch,y_batch) for key in key_list: network.params[key] -= learning_rate * grad[key] if i % 5 == 0: train_acc = network.accuracy(X_train, y_train) test_acc = network.accuracy(X_test, y_test) print("train acc : ", train_acc) print("test acc : ", test_acc) |

출력 :