Optimization theory

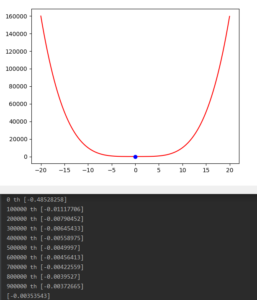

1차미분 gradient descent (step size : 0.01) 을 이용한 y = x**4 함수의 해 찾기

1,000,000번을 반복했지만 평평한 기울기 때문에 최적해인 0에 완벽히 수렴하지 못함.

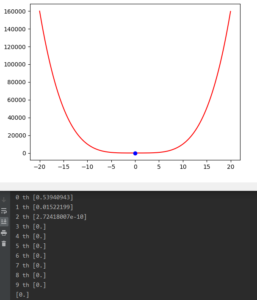

Newton’s method (2차 미분) 을 통한 반복법

단 3번 만에 최적해인 0 달성.

step size 를 이용한 2차미분 근사도 이론적으로 Newton’s method(2차미분) 과 동일

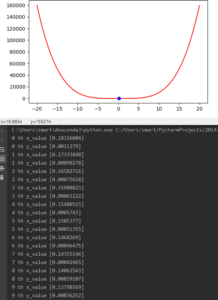

2차 미분을 이용한 탐색법의 문제는 아래와 같이 초기 값에 매우 민감하다.

y = x**4 함수

초기값을 조금 키우면 발산해버린다.

또한 다변수인 경우는 Hessian의 계산비용과 역행렬보장이 어렵다.